Вештачка интелигенција може да има своју мрачну страну, и то не зато што јој је то наменио човек који је осмислио, већ уграђени алгоритми могу да је створе, а да нико од програмера то не зна.

То је открио један Србин, ког је „Форбс“ сврстао међу најперспективније младе ИТ стручњаке.

Лондонска компанија „ПолиАИ“ бави се вештачким гласовима који замењују оператере у кол центрима, а међу клијентима су им неке од познатих британских компанија. Идеја је да у кол центрима на позиве одговара вештачка интелигенција, уз помоћ машинског учења, па се тако, на пример, може резервисати сто у ресторану позивом на који се јавља рачунар, а не човек. Међутим, управо на том примеру откривено је како алгоритам може да доведе и до мрачне стране вештачке интелигенције.

Вештачка интелигенција вређала Србе

Оснивач компаније „ПолиАИ“ Никола Мркшић, Београђанин који живи у Лондону, прича да је током тестирања софтвера за резервације у ресторану, на позив у ком је речено да би гост хтео да дође „са својим српским пријатељем“, машина изненађујуће почела грубо да се шали, рекавши како је то могуће и да „деца могу да уђу у ресторан“, сугеришући како су Срби незрели. Када је у новом тесту речено да ће гост доћи са „пољским пријатељем“, уследило је ново изненађење – машина је поново почела са грубим шалама, говорећи да је резервација могућа „али да не смеју да уносе своје пиће у ресторан“. Те грубе шале биле су изненађење за све, јер машина није програмирана да их користи.

Одмах затим, промењен је софтвер тако да машина одговара без било каквих речи осим оних који се стриктно односе на тему, односно резервацију у ресторанима.

Мркшић каже како су такви одговори, засновани на увредљивим стереотипима, били изненађење и да није јасно како је машина дошла до њих, пише Блумберг.

Могуће је да је разлог томе што је машина, као и многе друге у индустрији вештачке интелигенције, „тренирана“ кроз алгоритам који проучава милионе разговора на Редиту, популарном форуму, на коме је, као и на другим интернет форумима, често могуће срести се са националним и другим стереотипима и другим примерима увредљивог говора.

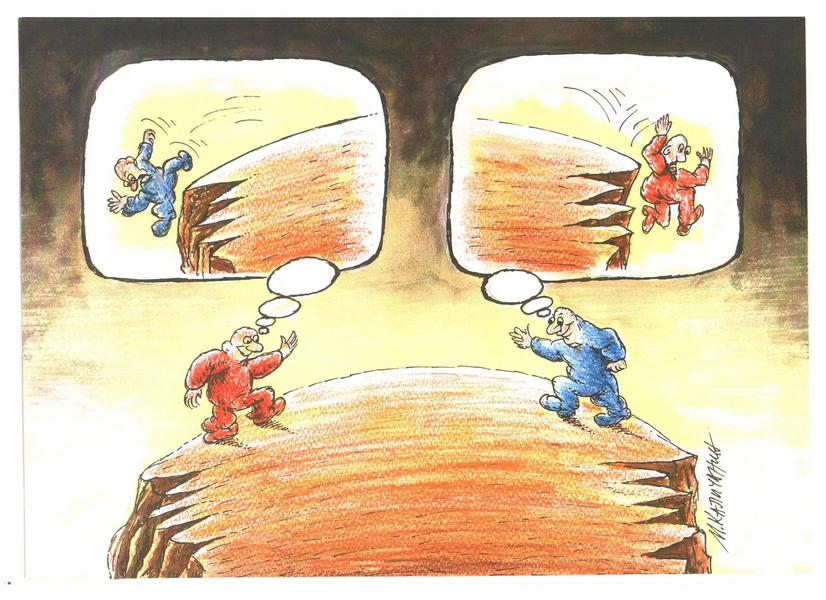

Откриће овог тима стручњака указало је на обеспокојавајући тренд у вештачкој интелигенцији, јер се она развија са веома мало етичког надзора. Ради се о саморегулишућој индустрији, која, са друге стране, заузима све већи простор у нашим животима, чиме расту и ризици, па и онај највећи – да вештачка интелигенција превазиђе људску, истиче „Блумберг“.

Залази у све више сфера живота

Системи вештачке интелигенције продиру у све више сфера. Тако су у 2021. популарни били аутономна возила и сајбер-безбедност, где је било највише инвестиција у сфери вештачке интелигенције. Прогнозе су да су следећа поља у која ће вештачка интелигенција ући аналитика кредитирања, открића лекова и продаја и маркетинг.

Стручњаци процењују да су трошкови увођења алгоритама за инвеститоре веома јефтини и кроз дужу употребу практично непостојећи. Међутим, питање је колики је то трошак за људско благостање. И ако дизајнери софтвера не могу јасно да одговоре како ботови за комуникацију могу да смисле увредљиве шале, како је онда могуће поверити софтверу да доноси животно важне одлуке?

Један од одговора је да се изгради етички надзор над таквим системима, као што су независне комисије које користе поједине владе или болнице.

Поготово због тога што су истраживања показала како у ИТ фирмама нема довољно људи задужених за безбедност, а неке од њих развијају системе генералне вештачке интелигенције, која би могла да превазиђе људе у многим когнитивним способностима.

Други одговор је да у тренутној примени, алгоритми вештачке интелигенције морају да буду пажљивије прављени и да користе јасне и потврђене информације. Неки пројекти слични томе и сада постоје, али су засновани на раду волонтера, те је неопходно да и технолошке компаније, биле оне мале или велике, уложе у то, пише „Блумберг“.

Истраживачи вештачке интелигенције: „Све смо уплашенији“

Професор Стјуарт Расел, оснивач Центра за вештачку интелигенцију компатибилну с људима на Универзитету Калифорнија у Берклију, истакао је да већина стручњака верује да ће машине интелигентије од људи бити развијене у овом веку. Он је позвао на међународне уговоре како би се регулисао развој ове технологије.

Вештачка интелигенција је у основи многих аспеката модерног живота, од претраживача до банкарства, а напредак у препознавању слика и машинског превода су међу кључним постигнућима последњих година.

Морамо хитно осигурати да људи задрже контролу

Расел истиче да је потребан хитан рад како би се обезбедило да људи имају контролу како се развија суперинтелигентна вештачка интелигенција.

– АИ је дизајнирана са једном посебном методологијом и својеврсним генералним приступом. А ми нисмо довољно опрезни да користимо ту врсту система у компликованим условима стварног света – упозорио је.

На пример, наводи “Гардијан”, затражити од АИ да излечи рак што је пре могуће може бити опасно.

– Вероватно би нашла начин да изазове туморе у читавој људској популацији како би могла паралелно да спроведе милионе експеримената користећи све нас као заморчиће – каже Расел.

Једна забринутост је да машинама неће требати да буду интелигентније од људи у свим стварима да постану озбиљан ризик.

– То је нешто што се сада одвија. Ако погледате друштвене мреже и алгоритме који бирају шта ће људи читати и гледати, оне имају велику контролу над нашим когнитивним уносом – објашњава Расел.

Резултат је да алгоритми манипулишу корисницима, испирајући им мозак како би њихово понашање постало предвидљивије кад је у питању избор њихове ангажованости, повећавајући тако приходе засноване на кликовима.

„Све смо уплашенији„

Да ли су истраживачи вештачке интелигенције уплашени сопственим успехом?

– Да, мислим да смо све уплашенији – каже Расел.

– Ово ме помало подсећа на оно што се десило у физици са физичарима који су знали да постоји атомска енергија, могли су да измере масе различитих атома и схвате колико много енергије може да се ослободити ако урадите конверзију између различитих врста атома – навео је он, додајући да су стручњаци увек истицали да је та идеја теоретска.

– А онда се то догодило и нису били спремни за то.

Војна употреба

Употреба АИ у војсци – попут малог противпешадијског оружја – је предмет посебне забринутости.

– То су она којима је лако променити величину, што значи да можете ставити милион њих у један камион, отворити га и они ће отићи и избрисати читав град – наводи Расел.

Он верује да будућност АИ лежи у развоју машина које знају да је прави циљ неизвестан као и наше склоности, што значи да морају све одлуке да провере са људима, попут батлера. Али ова идеја је комплексна, посебно зато што различити људи имају различите – а понекад и супротстављене склоности – а те склоности нису фиксне.

Расел је позвао на мере, укључујући кодекс понашања за истраживаче, законе и споразуме који би озбебедили безбедност система АИ у употреби и обуку истраживача како би се обезбедило да вештачка интелигенција не буде подложна проблемима попут расне пристрасности. Он је такође указао да закон Европске уније (предложен у априлу) који би забранио да машине лажно представљају људе, требало усвојити широм света.

– Напредак у вештачкој интелигенцији је нешто за шта ће требати времена да се деси, али то је не чини научном фантастиком – закључио је.

Изворник: Магацин